안녕하세요! 오늘은 PIG에 이어서, HIVE에 대해 알아보도록 하겠습니다.

HIVE

Hive는 하둡에서 데이터를 처리하기 위한 데이터 웨어하우징 솔루션 중 하나입니다. Hive는 SQL을 사용하여 대규모 데이터 집합을 분석할 수 있도록 해주는 데이터 웨어하우스 솔루션입니다. Hive는 하둡 기반의 분산 데이터 저장소에서 SQL 쿼리를 실행할 수 있도록 해주는 인터페이스를 제공합니다.

Hive는 HiveQL이라는 SQL과 비슷한 언어를 사용하여 데이터에 대한 쿼리 및 분석을 수행합니다. HiveQL은 기존의 SQL과 유사하며, 사용자는 대부분의 경우 HiveQL을 배우기 쉽습니다. 또한 HiveQL은 사용자가 쉽게 커스텀 함수와 집계 함수를 정의하고 사용할 수 있도록 해줍니다. Hive는 맵리듀스와 같은 하둡의 다른 기술과 함께 사용될 수 있으며, 대규모 데이터 처리 및 분석 작업을 수행하는 데 매우 유용합니다.

HIVE VS PIG

Hive와 PIG는 둘 다 Hadoop 기반의 데이터 처리 도구입니다. 기본적으로 두 처리 도구 전부 내부에서 맵리듀스 프레임워크를 사용하여 데이터 처리 작업을 수행하지만 둘의 목적과 기능이 다르며, 다른 방식으로 동작합니다. Hive는 SQL과 비슷한 HiveQL 쿼리 언어를 사용하여 대화형으로 데이터를 처리하는 데 중점을 둡니다.

반면 PIG는 데이터 처리 작업을 위해 스크립트 언어를 사용합니다. PIG 스크립트는 데이터 흐름을 정의하고, 중간 처리 결과를 다양한 방식으로 조작하고, 최종 결과를 생성하는 방식으로 동작합니다. 물론 두 도구는 함께 사용할 수 있습니다.

예를 들어 PIG로 처리한 중간 결과를 Hive로 불러와서 SQL 쿼리로 분석할 수 있습니다. 또는 Hive에서 처리된 결과를 PIG 스크립트로 조작할 수도 있습니다. Hive와 PIG는 각각의 장단점이 있으며, 사용하려는 데이터 처리 작업에 따라 선택할 수 있습니다. Hive는 SQL에 익숙한 사용자나 대화형으로 데이터를 처리하려는 경우에 유용합니다. PIG는 복잡한 데이터 처리 작업을 위해 구성 가능하며, 유연성과 확장성이 뛰어납니다.

HIVE의 디스크 기반 데이터 처리 방식

Hive는 디스크 기반 데이터 처리 솔루션입니다. Hive는 하둡의 HDFS(Hadoop Distributed File System)와 같은 분산 파일 시스템에서 데이터를 읽고 쓰기 때문에, 디스크 I/O가 필요합니다.

그러나 Hive는 디스크 기반으로 동작하면서도, 적절한 인덱싱 및 분할 기술을 사용하여 쿼리의 성능을 최적화할 수 있습니다. 예를 들어, Hive는 데이터를 분할하여 여러 노드에서 병렬로 처리할 수 있으며, 필요한 경우에만 필요한 데이터를 로드하여 처리할 수 있도록 하는 것과 같은 기술을 사용합니다.

또한 Hive는 메모리 캐시를 사용하여 쿼리의 성능을 향상시킬 수 있습니다. 쿼리 실행 시 자주 사용되는 데이터는 메모리에 캐시하여 디스크 I/O를 줄일 수 있습니다. 하지만 이러한 캐시 기능은 Hive가 메모리 기반으로 동작한다는 것을 의미하지 않습니다.

HIVE , PIG의 실행엔진 근황

Hive의 경우, 최근 버전에서는 Tez나 Spark와 같은 다른 실행 엔진을 사용할 수 있도록 지원합니다. Tez는 맵리듀스보다 효율적인 DAG(Directed Acyclic Graph) 기반의 실행 엔진입니다. Spark는 메모리 기반의 처리를 지원하며, 맵리듀스보다 더 빠른 속도로 데이터 처리 작업을 수행할 수 있습니다.

마찬가지로, PIG도 최근 버전에서는 Spark나 Tez와 같은 다른 실행 엔진을 사용할 수 있도록 지원합니다. 이러한 실행 엔진을 사용하면 맵리듀스보다 더 빠른 속도로 데이터 처리 작업을 수행할 수 있습니다. 따라서, Hive와 PIG는 맵리듀스를 사용하지 않을 수도 있으며, 다른 실행 엔진을 사용하여 데이터 처리 작업을 수행할 수 있습니다.

PIG로 가공한 데이터, HIVE로 받아 실습

(1) 데이터 가공 코드 .pig 파일로 만듭니다. 파일명은 wh_visits.pig로 저장합니다.

(2) pig wh_visits.pig 명령을 통해, wh_visits.pig 파일을 실행합니다.

- 이 때 가공할 데이터인 visits.txt는 HDFS의 특정 경로에 저장되어 있어야합니다.

(3) 실행이 잘 되었는지 확인합니다.

hadoop fs -ls /user/hive/warehouse/wh_visits/

-- hortonwork인 경우

hadoop fs -ls /warehouse/tablespace/managed/hive/wh_visits/

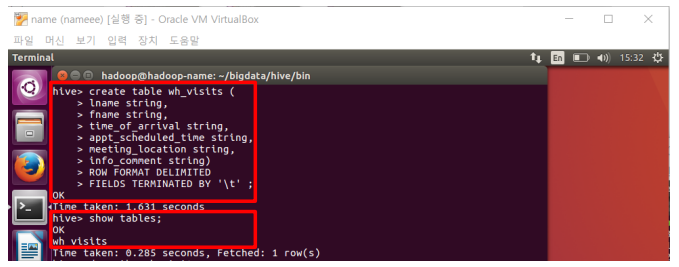

(4) Hive를 실행시키고, 가공된 데이터를 활용해서 테이블을 생성합니다.

hive

-- 일반적인 경우

create table wh_visits (

lname string,

fname string,

time_of_arrival string,

appt_scheduled_time string,

meeting_location string,

info_comment string

)

ROW FORMAT DELIMITED

FIELDS TERMINATED BY ‘\t’;

-- hortonwork인 경우

create table wh_visits (

lname string,

fname string,

time_of_arrival string,

appt_scheduled_time string,

meeting_location string,

info_comment string

)

ROW FORMAT DELIMITED

FIELDS TERMINATED BY '\t'

STORED AS TEXTFILE;

(5) 생성한 테이블의 속성을 확인하고, wh_visits 테이블의 데이터를 20개만 검색해봅니다.

describe wh_visits;

select * from wh_visits limit 20;

PIG에서 가공한 파일을 그대로 HIVE에서 받는 방법이였습니다. HIVE로 넘겨온 파일은 HIVEQL을 활용하는데, 이는 SQL 문법과 거의 동일합니다. 이렇듯 PIG에서 가공된 데이터를 HIVE로 넘기는 방법, 그리고 HIVE에서 넘어온 데이터를, 다시 PIG로 가공하는 다양한 방법이 있습니다.

HIVE 내부 테이블 , 외부 테이블(외부 테이블 권장)

내부 테이블은 테이블을 삭제하면 테이블 메타 데이터와 데이터가 삭제됩니다. 하지만, 외부 테이블을 삭제하면 테이블 메타 데이터는 삭제되지만 데이터는 삭제되지 않습니다.

외부 테이블은 테이블을 생성할 때, EXTERNAL 키워드를 사용하며, LOCATION절을 추가로 사용해 하둡 파일 시스템 내 지정한 위치에 데이터가 존재한다는것을 Hive에게 알려줌으로써, 테이블을 생성합니다. 외부 테이블을 삭제하면, 하이브 내에서 스키마만 삭제될 뿐 데이터는 그대로 존재하기 때문에 중요한 데이터의 경우 실수를 방지하기 위해 외부 테이블로 만드는것을 권장한다고 합니다.

CREATE EXTERNAL TABLE names (id int, name string) ROW

FORMAT DELIMITED FIELDS TERMINATED BY '\t'

STORED AS TEXTFILE LOCATION '/user/root/hivedemo';CREATE에 EXTERNAL을 붙이고, LOCATION을 HDFS 내의 경로를 지정해줍니다. 이렇게 하면, 테이블을 삭제했을 때, 원본 데이터를 삭제하지 않고, 그대로 테이블만 DROP 시킵니다.

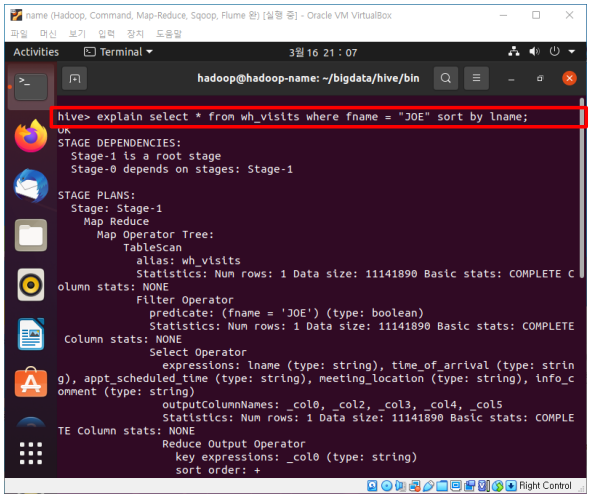

EXPLAIN 문

SQL과 같이 HIVE에도, EXPLAIN 문이 있고, 쿼리 처리에 대한 더 상세한 정보를 파악할 수 있습니다.

explain select * from wh_visits where fname ='JOE' sort by lname;

이렇게 오늘은 HIVE에 대해서 알아봤습니다. 감사합니다:)

'데이터 엔지니어링 > 하둡 에코 시스템' 카테고리의 다른 글

| [MongoDB]pymongo로 간단한 프로그램 만들기 (3) | 2023.05.18 |

|---|---|

| [MONGODB] 몽고DB 로컬에 설치하고 파이썬 연동하기 (0) | 2023.05.18 |

| [PIG] 기본 개념 및 실습 (0) | 2023.05.12 |

| [Flume] 기본 개념 및 설치 (0) | 2023.05.10 |