- 윈도우 10+ 기반

- JDK11과 파이썬 3.8 혹은 그 이상을 설치

java -version

python --version

SPARK 3.0 설치

1. C드라이브의 루트 밑에 Spark, Hadoop이라는 폴더를 생성한다.

- Spark: C:\Spark

- Hadoop: C:\Hadoop

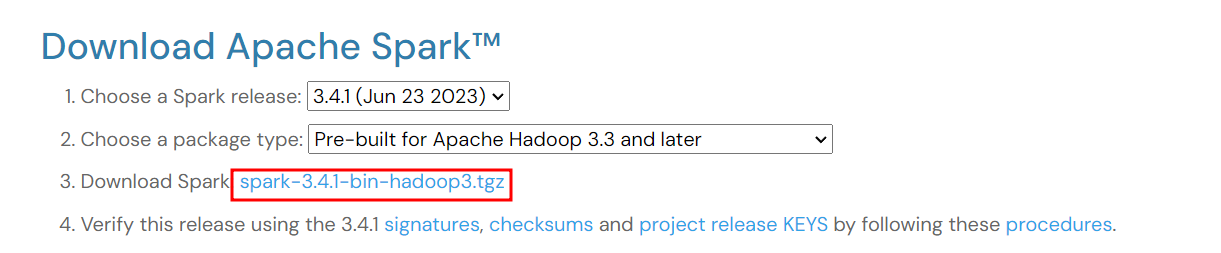

2. 아래 링크 방문 후 가장 최신 버전을 다운로드. 다운로드 파일을 Spark 폴더에서 압축 풀기

https://spark.apache.org/downloads.html

Downloads | Apache Spark

Download Apache Spark™ Choose a Spark release: Choose a package type: Download Spark: Verify this release using the and project release KEYS by following these procedures. Note that Spark 3 is pre-built with Scala 2.12 in general and Spark 3.2+ provides

spark.apache.org

3. Hadoop 폴더 밑에 bin 폴더를 생성한 뒤, 아래 링크에서 winutils.exe를 받아 bin 폴더 안으로 옮긴다.

https://github.com/cdarlint/winutils/blob/master/hadoop-2.7.7/bin/winutils.exe

4. 환경 변수 설정

- 시스템 환경변수 설정에서 시스템 변수의 새로 만들기를 누르고 시스템 변수로 아래 환경 변수들을 설정한다.

- HADOOP_HOME: C:\Hadoop

- SPARK_HOME: C:\Spark\spark-3.4.1-bin-hadoop3

- 해당 부분은 버전에 맞춘다.

- JAVA_HOME: JDK가 설치된 디렉토리에 맞춰 지정

- Path에 다음 두개 추가

- %SPARK_HOME%\bin

- %HADOOP_HOME%\bin

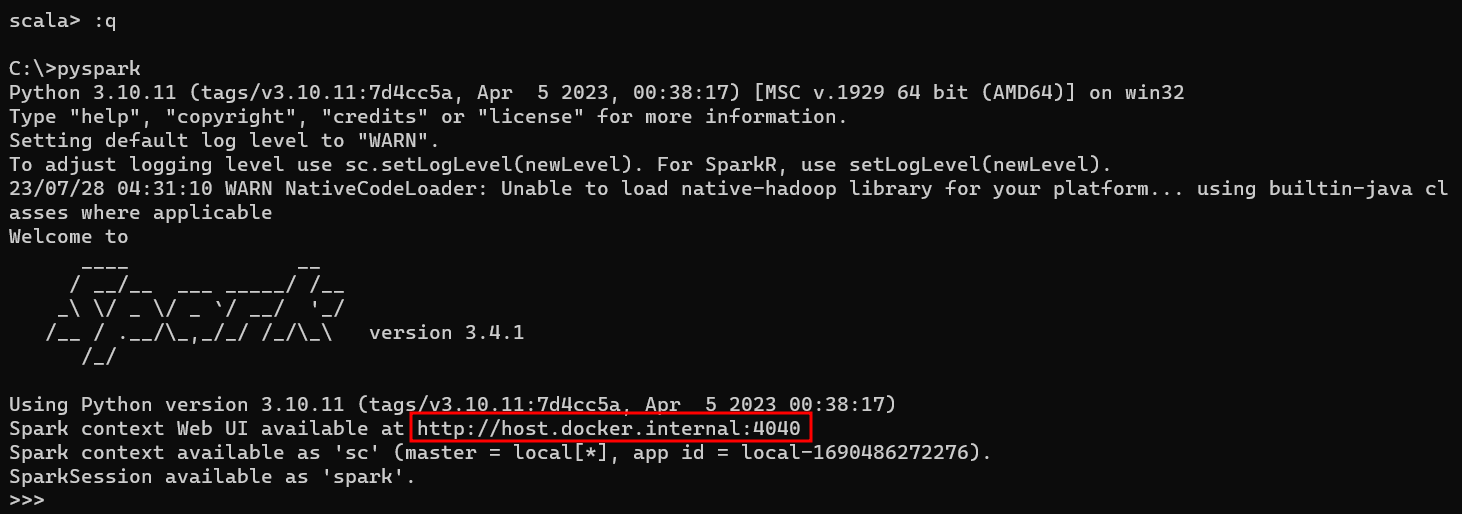

5. 실행해보기(pyspark)

- cmd로 들어간 뒤 spark-shell 혹은 pyspark 입력

- 예제로 pyspark 실행

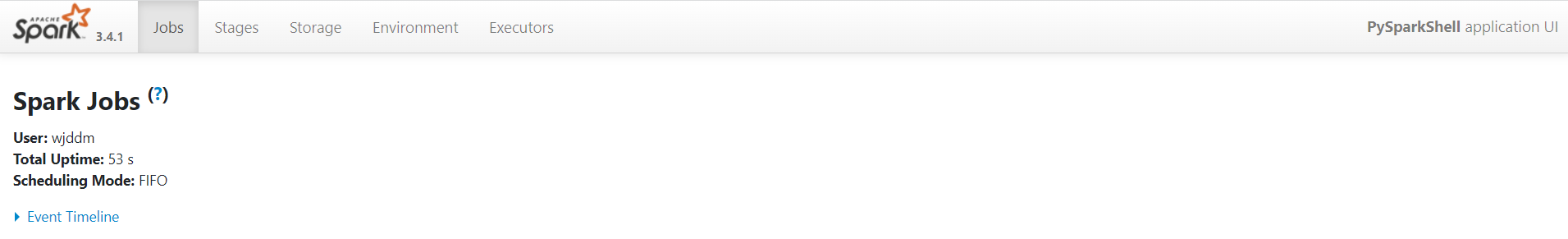

- 웹 주소 접속

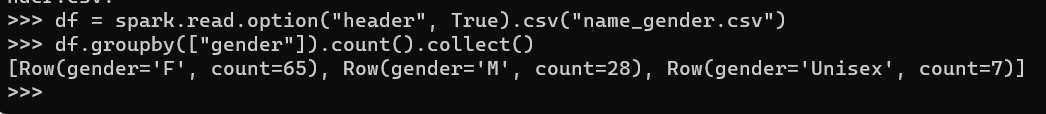

- shell 상에서 데이터 프레임 방식 가공 예제(실행 시킨 폴더에 csv 파일 넣어두면 됩니다)

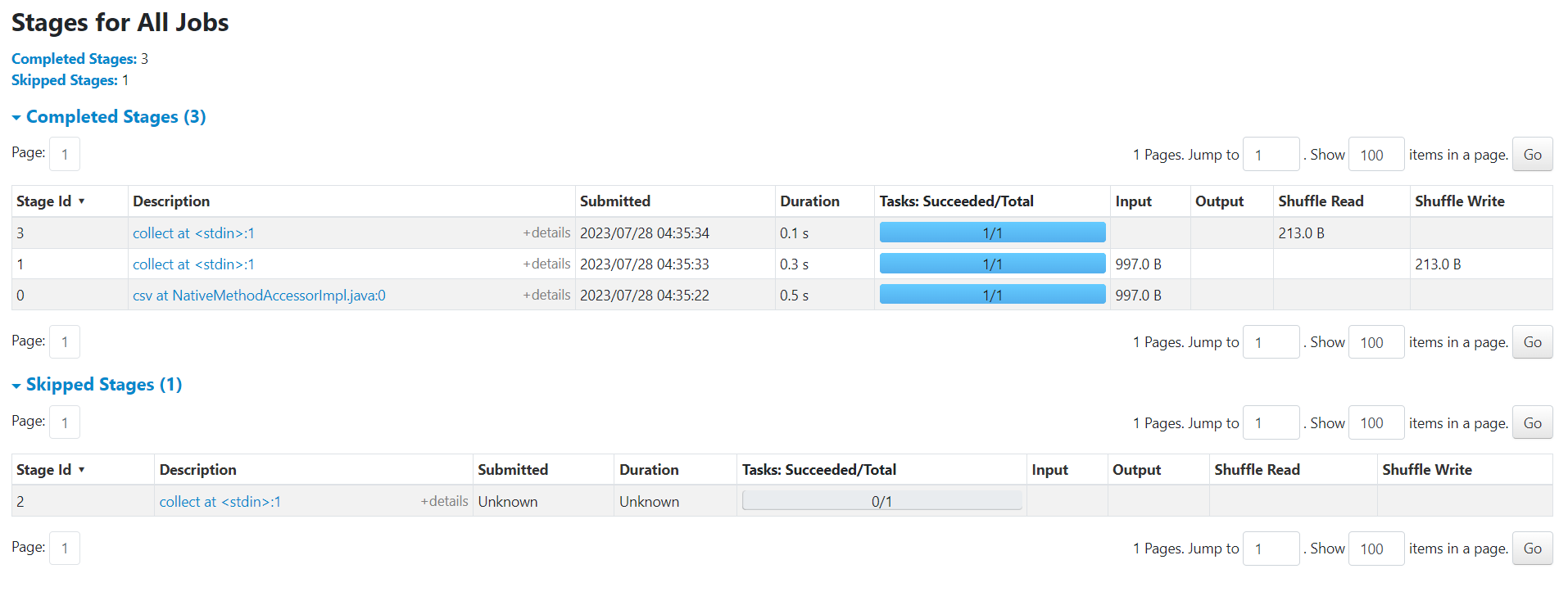

- 가공하면 Web UI 상에 무언가 올라옵니다.

- 자세한 설명은 다음 포스팅에서 진행하겠습니다.

6. 예제 실행해보기(Spark-submit)

spark-submit --master local[4] ./spark-3.4.1-bin-hadoop3/examples/src/main/python/pi.py

Spark-submit 오류 해결, 윈도우에서 편하게 작업하기

1. window 환경에서 spark shell, pyspark는 되는데, spark-submit은 안되는 경우

윈도우에서 pyspark와 spark 간 연결이 안 되어있어 생기는 문제라고 합니다.

환경변수에서 새로만들기 -> 변수 이름 : PYSPARK_PYTHON, 변수값 : python

이렇게 설정하시면 잘 됩니다.

2. conda 가상환경에서 Spark 작업하고자 하는 경우

pyspark import 전에

import findspark

findspark.init()

이 코드를 추가해주시면, pyspark를 보통 라이브러리처럼 import 해서 사용하실 수 있습니다.

(spark-submit 시에는 코드를 주석 처리 해줘야합니다)

참고 자료:

https://stackoverflow.com/questions/53252181/python-worker-failed-to-connect-back

https://spidyweb.tistory.com/199

'데이터 엔지니어링 > Spark' 카테고리의 다른 글

| 9. Spark DataFrame 실습(Alias, catalog) (0) | 2023.08.17 |

|---|---|

| 8. Spark DataFrame 실습(SparkSession, conf, Schema, Filter, select, SparkSQL, sql.types, 컬럼지칭 방식) (0) | 2023.08.17 |

| 6. Spark(개발환경 옵션, Local Standalone, 활용 Demo) (0) | 2023.07.28 |

| 5. Spark 프로그램 구조(Spark Session 생성, 환경변수) (1) | 2023.07.11 |

| 4. Spark 프로그래밍 : DataFrame(데이터처리, 동작구조) (0) | 2023.07.11 |